ct.html

CTXT

Seguridad

Los riesgos del reconocimiento facial

Ante la inminente aprobación de la ley europea sobre

Inteligencia Artificial, las autoras alertan sobre los sesgos en el

entrenamiento algorítmico y la posible intromisión en la

intimidad de las personas

Simona Levi / Miriam Carles / Sanne Stevens 13/06/2023

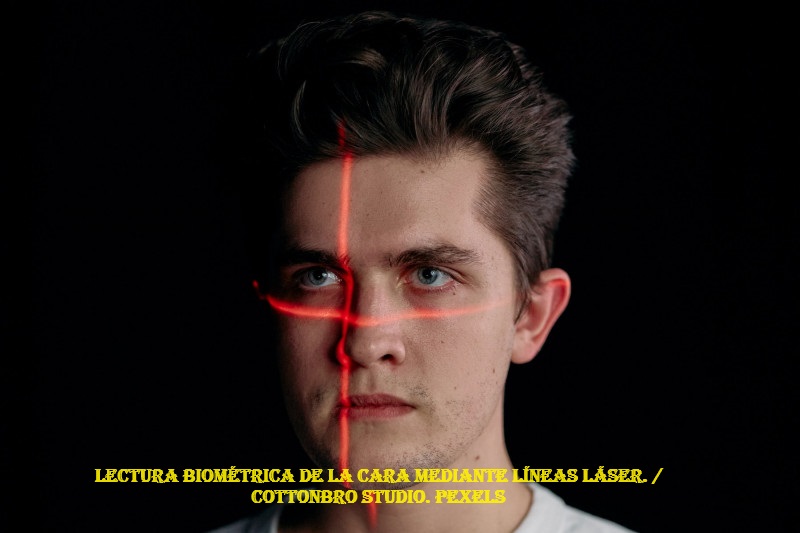

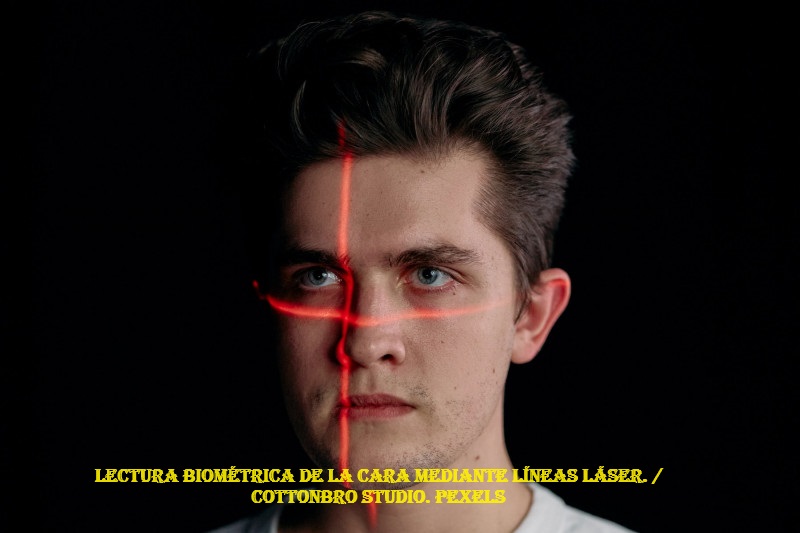

Hay multitud de identificadores biométricos. Algunos son de

comportamiento, como el reconocimiento de la firma, la voz, la

escritura o la manera de andar. Otros son fisiológicos, como la

huella dactilar, el iris o la retina, el reconocimiento vascular,

facial o de la geometría de la mano. Estos últimos se han

hecho populares a modo de código para identificar a las personas

de forma unívoca, entendiendo el cuerpo como un recurso de

exactitud y precisión que puede funcionar como

“contraseña”.

En lo que respecta a la biometría para el reconocimiento

personal, cualquier característica biológica o de

comportamiento es utilizable como identificador biométrico si

cumple al menos cuatro requisitos básicos: coleccionabilidad (el

elemento se puede capturar), universalidad (el elemento existe en todas

las personas), unicidad (el elemento debe ser distintivo por cada

persona) y permanencia (la propiedad del elemento permanece en el

tiempo).

Las organizaciones internacionales de referencia en la defensa de los

derechos humanos en el ámbito digital coincidimos en que

“el acelerado crecimiento en el uso de tecnologías

biométricas para la identificación (…) plantea una

serie de cuestiones relativas no sólo al impacto de estas

tecnologías sobre la libertad de expresión y de

acción en espacios públicos, sino a la autonomía y

a la identidad del individuo”, como explica este informe de

Marianne Díaz para derechos digitales.

A diferencia de una contraseña, los

indicadores biométricos no pueden simplemente restablecerse o

cambiarse según sea necesario

Los datos biométricos son vulnerables a ataques, al igual que

otros métodos de autenticación. Sin embargo, a diferencia

de una contraseña, los indicadores biométricos no pueden

simplemente restablecerse o cambiarse según sea necesario. Esto

plantea un mayor riesgo de seguridad, puesto que se hace cada vez

más difícil reparar el daño causado por fugas o

ataques y restaurar el buen funcionamiento de los sistemas basados en

biometría y la integridad física de las personas

involucradas.

No son más seguros. Recientemente, el riesgo que comporta el uso

malicioso de esta información se ha agravado con la

suplantación de identidad mediante deep fakes o deep voices en

los que interviene la IA. Ya es posible incluso crear “huellas

maestras” que combinen las características comunes de

varias personas permitiendo su identificación con una sola

huella.

Es prácticamente imposible recuperar la

privacidad del individuo ya que no se puede cambiar de identidad de la

cara, una información permanentemente expuesta

Así pues, el principal inconveniente del uso de estas

tecnologías es que, una vez se pierde el control, es

prácticamente imposible recuperar la privacidad del individuo ya

que no se puede cambiar de identidad ni de cara, una información

permanentemente expuesta, ni las huellas dactilares, que, a pesar de no

estar tan expuestas, tienen la peculiaridad de que pueden ser recogidas

también sin que el individuo se dé cuenta, tal y como ha

enfatizado incluso la Comisión Nacional de la Informática

y las Libertades.

Nada es más personal que la propia cara. Reúne varios

elementos que configuran nuestras identidades únicas. La

recogida, análisis y almacenamiento de datos personales innatos

es altamente invasiva e incluso puede revelar más

información sobre una persona, como sus datos de salud.

Los programas de reconocimiento facial, incluidos los sistemas de

verificación e identificación, crean, recogen, comparan y

retienen plantillas faciales de las personas. Aunque el reconocimiento

facial eclosionó hace tiempo en el ámbito de la

investigación privada y académica, recientemente las

administraciones, gobiernos y legisladores le han empezado a prestar

atención.

La magnitud de los problemas con la tecnología de reconocimiento

facial resuena por las muchas ciudades que han decidido prohibirla. Sin

embargo, otras ciudades y pueblos han invertido grandes cantidades en

esta tecnología y empresas como Clearview AI, TrueFace,

AnyVision, Affectiva, Kairos, Accenture, BioID o Leidos han hecho su

agosto.

El reconocimiento facial tiene un alto riesgo de automatizar sesgos ya penetrantes en las sociedades

En palabras del Comité Europeo de Protección de Datos,

“el reconocimiento facial puede socavar el derecho al respeto de

la vida privada y la protección de los datos personales, pero

también otros derechos y libertades fundamentales (en particular

la libertad de expresión e información, la libertad de

reunión y asociación y la libertad de pensamiento,

conciencia y religión). Además, puede afectar a la

expectativa razonable de anonimato de los individuos en los espacios

públicos y plantea cuestiones más amplias desde el punto

de vista ético y social”. También se ha demostrado

que estos sistemas tienen muchos problemas de precisión, por

ejemplo, tienden a ser menos precisos para identificar a personas

negras. En las pruebas que realizó la policía de Londres

con esta tecnología para buscar a sospechosos se produjeron gran

cantidad de errores y falsos positivos.

El procesamiento de datos biométricos se basa en estimaciones

estadísticas de coincidencia entre los elementos comparados. Por

tanto, es intrínsecamente falible. La respuesta que ofrece un

sistema de comparación biométrica nunca es binaria

(sí o no); sino que es una probabilidad de coincidencia.

Además, las plantillas biométricas calculadas son siempre

distintas en función de las condiciones en las que se calculan

(luminosidad, ángulo, calidad de la imagen, resolución de

la cara, etc.). Así pues, cualquier dispositivo se caracteriza

por un rendimiento variable en función, por un lado, de los

objetivos que se le asigne y, por otro, de las condiciones en las que

se recogen las imágenes y se comparan. Esto significa

además que el reconocimiento facial tiene un alto riesgo de

automatizar sesgos ya penetrantes en las sociedades.

Algunos ejemplos:

– Policía de Londres. Después de escanear las caras

de 8.600 personas para buscar criminales, de ocho identificaciones

realizadas, siete resultaron erróneas.

– Congresistas de Estados Unidos. En 2018, la tecnología

de reconocimiento facial de Amazon confundió a 28 congresistas

con criminales condenados cuando la American Civil Liberties Union

(ACLU) cruzó una base de datos con 25.000 fotos públicas

de delincuentes con las fotografías de 535 miembros del Congreso.

– Registro nacional de personas buscadas por la policía.

En Buenos Aires se puso en marcha un sistema de reconocimiento facial

en vivo para encontrar a prófugos. Un niño de cuatro

años fue considerado sospechoso de haber cometido “delitos

de lesiones graves contra las personas”.

– Fútbol. Una cámara controlada por inteligencia

artificial confundió la cabeza de un árbitro (calvo) con

la pelota.

– Estudio sobre la influencia de la demografía en el

rendimiento de los algoritmos de reconocimiento facial. Los resultados

demuestran que los algoritmos son menos precisos en la

identificación de mujeres, personas negras y entre las edades de

18 a 30 años.

Además, debe considerarse la desviación de la

utilización de datos altamente sensibles. La paulatina

ampliación del uso de datos, de una tecnología o sistema

más allá de la finalidad para la que estaba pensada

originalmente, es un problema habitual, lo que a menudo conduce a una

posible invasión de la privacidad y mal uso de la

información. Este riesgo es aún mayor, ya que a menudo

existe una colusión entre registros públicos delicados y

empresas privadas que construyen estas herramientas y bases de datos.

Son notorios los casos recientes de empresas que no cumplen las normas

básicas de privacidad de datos y que utilizan imágenes

sin consentimiento para entrenar sus algoritmos.

La posible intromisión ilegítima en la

intimidad de las personas implican que los riesgos siguen siendo

mayores que los beneficios obtenidos

En resumen, como señala la Comisión Nacional de la

Informática y las Libertades francesa, “el reconocimiento

facial, como otras técnicas biométricas, nunca es un

tratamiento completamente inofensivo. Incluso el uso muy encuadrado

puede, en caso de ciberataque, compromiso o error, tener consecuencias

especialmente graves”.

A la vista de lo expuesto, creemos que los sistemas que incluyan

reconocimiento biométrico y/o facial basados en IA pueden

suponer un grave ataque a los derechos y libertades fundamentales,

aún cuando cumplen con los criterios de usabilidad,

transparencia, auditabilidad y rendición de cuentas.

En concreto, la posibilidad de causar perjuicios discriminatorios a

consecuencia de los sesgos en el entrenamiento algorítmico y la

posible intromisión ilegítima en la intimidad de las

personas implican que los riesgos siguen siendo mayores que los

beneficios obtenidos con su uso.

Creemos que la IA puede mejorar la vida de las personas y la organización social. Pero deben tener tenerse

en cuenta criterios éticos, así como los derechos

humanos, el derecho de elección, la minimización desde el

diseño y por defecto o la titularidad no monetizable, entre

otras muchas salvaguardias como base de cualquier protocolo si no

queremos que el efecto sea justo el contrario.